O que é fotografia computacional e qual é a sua importância para smartphones

]]>

Índice

- Quando surgiu a fotografia computacional?

- Quais as limitações da fotografia mobile?

- O celular já pode substituir uma câmera profissional?

- Exemplos de técnicas de fotografia computacional

- HDR e Smart HDR

- Modo noturno

- Deep Fusion e Photonic Engine

- Pixel binning

- Modo retrato

- Astrofotografia

- Zoom espacial

- Diferentes abordagens de machine learning em fotografia

Quando surgiu a fotografia computacional?

O primeiro conceito de fotografia computacional surgiu em 1936 em um artigo do pesquisador Arun Gershun que descrevia o “campo luminoso”, uma função que estabelece a quantidade de luz que viaja em todas as direções através de todos os pontos do espaço.

Em 1996, Marc Levoy e Pat Hanrahan implantaram o campo luminoso em computação gráfica e propuseram “um método para criar novas visualizações a partir de posições arbitrárias de uma câmera simplesmente combinando e reamostrando as imagens disponíveis”.

No entanto, a fotografia computacional só se tornou popular na década de 2010 com a evolução dos processadores de imagem nos smartphones, que passaram a executar tarefas de inteligência artificial, redes neurais e aprendizagem de máquina para melhorar a qualidade das fotos com baixo consumo de energia.

O Google popularizou o conceito de fotografia computacional em 2016 com os celulares Pixel, que tiravam boas fotos com uma câmera de abertura de lente f/2,0 e um sensor de 12 MP, enquanto rivais apostavam em câmeras com especificações superiores. O sucesso do software da câmera é atribuído principalmente a Marc Levoy, que ficou no Google até 2020.

Outras técnicas de fotografia computacional foram desenvolvidas por fabricantes de smartphones, como Xiaomi, Huawei e Samsung. A Apple lançou em 2019 o Deep Fusion, que processa nove imagens para criar uma foto mais nítida, e aprimorou sua tecnologia em 2022 com o Photonic Engine.

Quais as limitações da fotografia mobile?

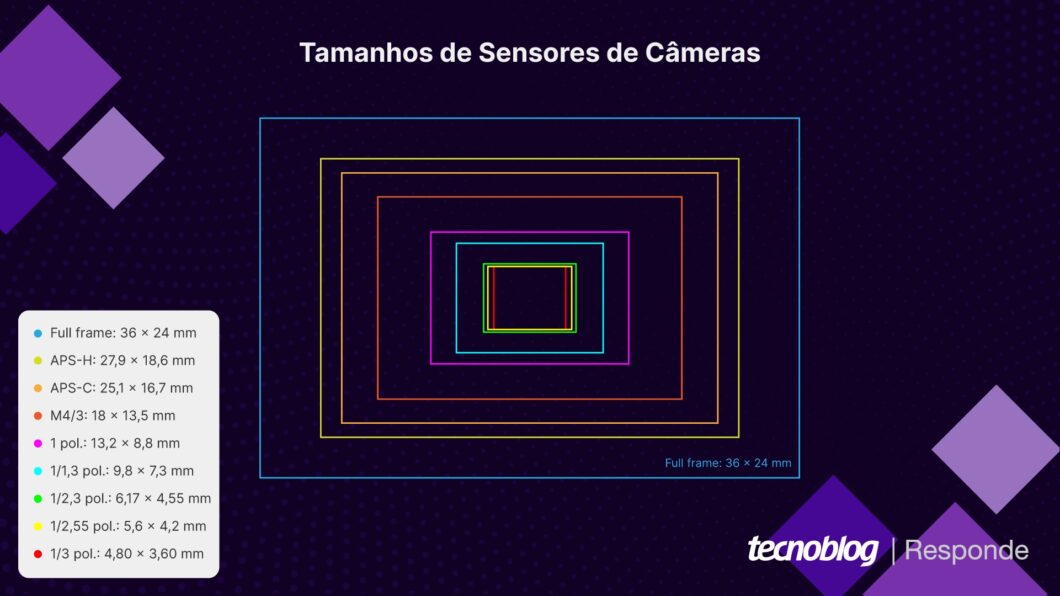

Celulares têm hardware fotográfico inferior ao de câmeras dedicadas devido a limitações físicas. Enquanto câmeras mirrorless ou DSLR podem ser equipadas com grandes sensores de imagem, um smartphone precisa ter um componente mais compacto, o que restringe sua capacidade de captura de luz.

Um sensor menor precisa de uma sensibilidade ISO maior para capturar a mesma quantidade de luz, o que pode causar ruídos na imagem. Além disso, como os pixels do sensor de um celular são menores, o alcance dinâmico das fotos tende a ser inferior, o que pode gerar imagens com regiões estouradas ou subexpostas.

O conjunto óptico dos celulares também é limitado. Em regra, as lentes têm abertura fixa, o que impede o controle da profundidade de campo e, portanto, não permite o desfoque natural do fundo, o chamado efeito bokeh. Além disso, a distância focal geralmente fixa impede que a lente tenha zoom óptico variável.

O celular já pode substituir uma câmera profissional?

O celular não substitui completamente uma câmera profissional devido às limitações de hardware. Apesar de ter capacidade de processamento maior, um smartphone não pode capturar a mesma quantidade de detalhes que um sensor de DSLR, nem fotografar em todas as condições que uma câmera com lentes intercambiáveis.

Nosso comparativo entre smartphones, câmeras DSLR e mirrorless mostra em detalhes as vantagens e desvantagens de cada tipo de equipamento.

Exemplos de técnicas de fotografia computacional

HDR e Smart HDR

O HDR amplia o alcance dinâmico, ou seja, a diferença entre as áreas mais claras e mais escuras da imagem. Essa técnica de fotografia computacional tenta resolver a limitação do tamanho do sensor dos celulares.

Ao tirar uma foto em HDR, o celular captura várias fotos em sequência, cada uma com níveis diferentes de exposição, e o processador de imagem combina as informações em um único arquivo. O Smart HDR foi lançado pela Apple em 2018 e capturava até 9 imagens em menos de 1 segundo.

A técnica permite que o celular escolha as melhores partes de cada foto, como as áreas mais escuras de uma imagem superexposta e as mais claras de uma imagem subexposta. O resultado é uma foto com mais detalhes visíveis tanto nas regiões mais claras quanto nas mais escuras, o que melhora as cores e o contraste.

Modo noturno

O modo noturno, também chamado de Modo Noite ou Night Vision dependendo da fabricante, melhora a qualidade de uma fotografia em condições de baixa iluminação. Ele compensa a capacidade limitada de captura de luz dos sensores de imagem dos celulares.

O recurso funciona de diferentes maneiras. Ele pode tirar várias fotos em sequência e combiná-las posteriormente para reduzir o ruído, ou manter o obturador aberto por mais tempo para permitir a entrada de mais luz. Depois, o processador de imagem aumenta o brilho enquanto reduz o ruído da foto.

Deep Fusion e Photonic Engine

Deep Fusion é uma tecnologia da Apple que tira nove fotos em sequência e usa o processador neural do iPhone para compor uma foto com melhor alcance dinâmico, maior nível de detalhes e menos ruído. O chip usa técnicas de deep learning (aprendizagem profunda) para identificar a cena e aplicar as melhores configurações.

Photonic Engine é uma evolução do Deep Fusion que processa as imagens com inteligência artificial antes que elas sejam comprimidas. Isso permite que o Neural Engine atue com uma quantidade de dados maior e melhore ainda mais a exposição, o contraste, a textura e outras características da foto.

Pixel binning

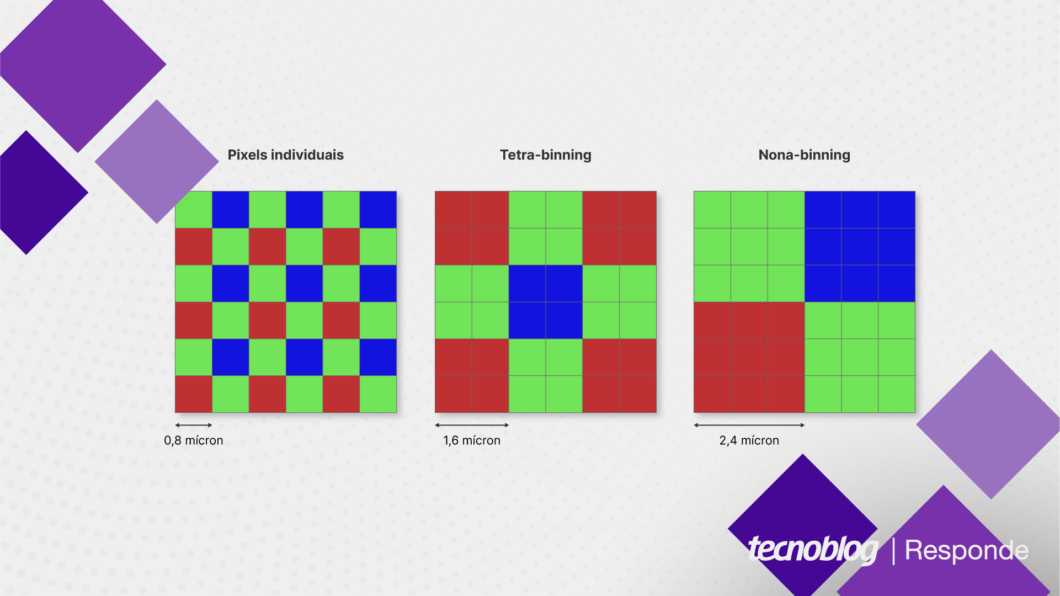

O pixel binning combina vários pixels adjacentes do sensor de imagem em um único pixel, muitas vezes chamado de “superpixel”. O objetivo é contornar o tamanho pequeno dos pixels dos sensores de celulares, que podem gerar mais ruído e capturar menos luz.

A técnica tetra-binning (2×2), por exemplo, combina 4 pixels em um. Dessa forma, um sensor de 48 MP com essa tecnologia gera uma foto de 12 MP que possui maior nível de detalhes e ocupa menos espaço na memória do aparelho. Outros arranjos são frequentemente encontrados em sensores de alta resolução, como 108 e 200 MP.

Modo retrato

O modo retrato permite criar uma foto com fundo desfocado. O efeito é semelhante ao bokeh que acontece nas lentes com grandes aberturas, quando o sujeito principal da foto permanece totalmente focado enquanto o fundo aparece borrado. O bokeh não acontece naturalmente nos celulares devido à ampla profundidade de campo.

No modo retrato, o celular pode tirar duas fotos: uma para o sujeito principal, outra para o fundo. Depois, o processador de imagem junta as duas imagens, borrando digitalmente a que contém o fundo. Sensores de profundidade e ToF podem identificar a profundidade em 3D da foto, gerando recortes mais precisos do fundo.

Astrofotografia

O modo astrofotografia permite capturar imagens do céu noturno com mais detalhes e nitidez. Ele funciona reduzindo a velocidade do obturador para permitir que mais luz chegue até o sensor e compensando digitalmente efeitos indesejados, como tremidos na câmera ou o movimento das estrelas, que gerariam rastros na foto.

O Google Pixel 6 Pro, de 2021, embutiu recursos de astrofotografia em seu modo noturno, chamado de Night Sight. Quando apoiado em um tripé ou outra superfície, o celular tira foto das estrelas após manter o sensor exposto por 4 minutos. O Samsung Galaxy S22 também foi lançado com um recurso similar em 2022.

Zoom espacial

Zoom espacial, Space Zoom, zoom de 100x e outras tecnologias similares usam zoom híbrido para atingir longas distâncias focais em uma câmera de celular. O objetivo é tirar fotos de objetos muito distantes mesmo com uma lente pequena, que caiba em um aparelho compacto.

Ele combina o zoom óptico da lente teleobjetiva ou periscópica com o zoom digital. Se houver zoom óptico de 10x mais um digital de 10x, é possível fotografar a lua gerando menos artefatos e ruídos que em um zoom digital puro de 100x. O processador de imagem também atua para reduzir os problemas causados pelo zoom digital.

Diferentes abordagens de machine learning em fotografia

Fabricantes de celulares podem usar diferentes abordagens de fotografia computacional para criar fotos visualmente mais interessantes.

A Apple, por exemplo, tende a usar machine learning para aumentar o realismo das fotos, melhorando a nitidez de uma imagem com o Deep Fusion e o Photonic Engine. O objetivo é ressaltar detalhes já existentes que a câmera do iPhone não consegue capturar com precisão.

Já outras marcas, como a Samsung e a Huawei, chegaram a usar fotografia computacional para criar novas fotos. O Galaxy S23 Ultra, por exemplo, adiciona texturas de alta resolução da lua quando o usuário tenta capturar uma foto do satélite. Oficialmente, a empresa nega fazer sobreposição de imagens.

O que é fotografia computacional e qual é a sua importância para smartphones

localização de celular

Fonte: https://tecnoblog.net/responde/o-que-e-fotografia-computacional/

Reviewed by MeuSPY

on

junho 01, 2023

Rating:

Reviewed by MeuSPY

on

junho 01, 2023

Rating:

Nenhum comentário:

Antes de deixar um comentário, acesse o site meuspy.com e veja como é fácil espionar celulares.